【论文笔记】Fedprox

0 Paper Info

原文地址:Federated Optimization In Heterogeneous Networks

录用会议:Conference on Machine Learning and Systems, MLSys

录用年份:2020

1 Introduction

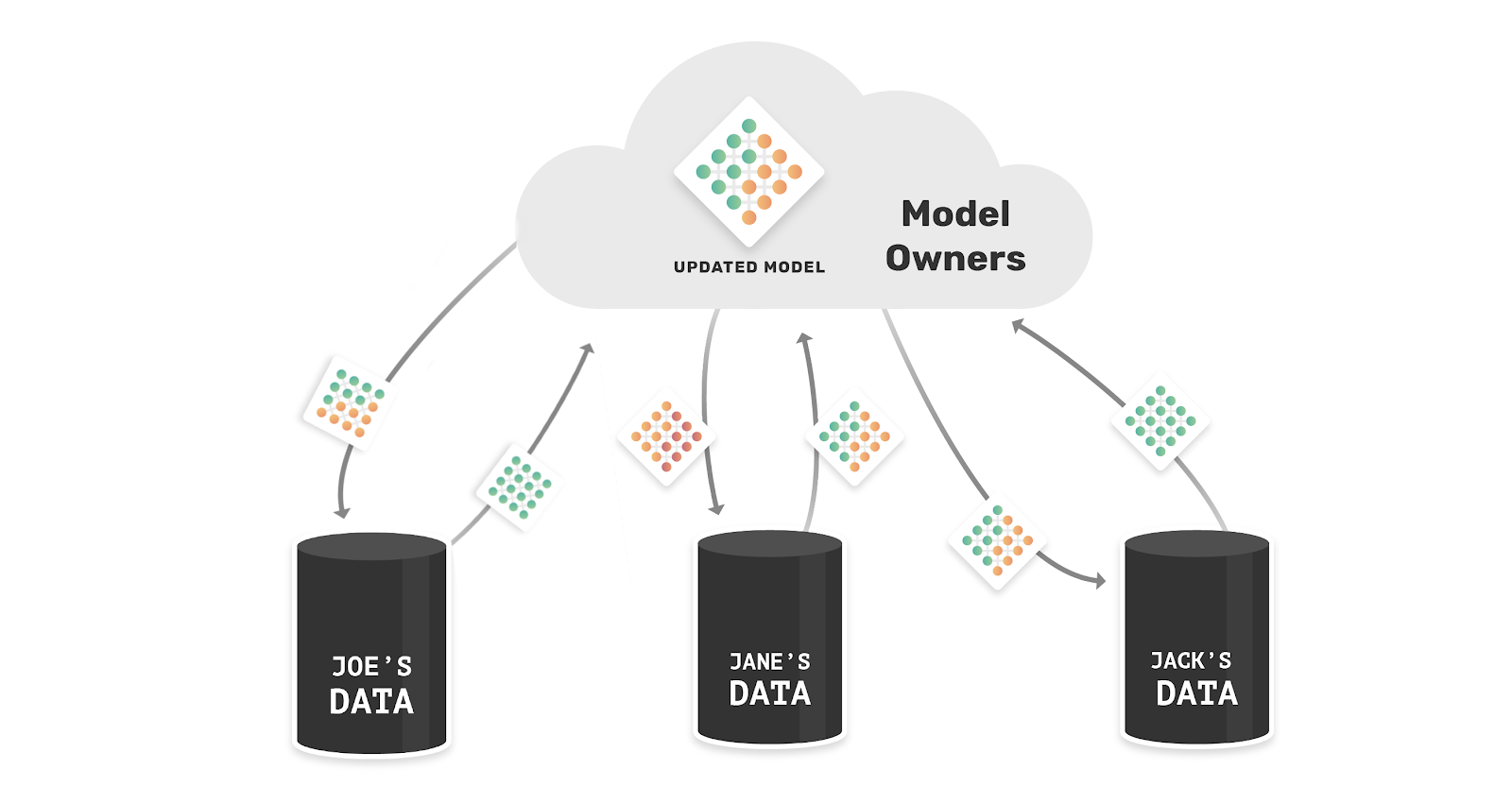

机器学习背景下,分布式优化已经有了大量的工作,但是在联邦学习场景下仍有区别于传统分布式优化的挑战,如系统异构性和统计异构性,2017年提出来的FedAvg在不同场景异构的情况下有如下缺陷:

- 系统异构(System Heterogeneity):联邦学习场景下不同设备的通信和计算能力存在差异。在FedAvg中,被选中的客户端都需要利用自己的私有数据集在本地训练相同的epoch,虽然增加客户端的epoch可以有效减小通信成本,但客户端epoch较大时会导致很多设备无法按时完成训练。无论是直接drop掉这部分的模型还是用这部分未完成训练的模型来聚合,都会对全局模型的收敛产生负面影响

- 统计异构(Statistical Heterogeneity):不同设备的私有数据可能是非独立同分布(Non-IID)的。在数据独立同分布的情况下,增加客户端的epoch可以加快全局模型的收敛;但是如果不是独立同分布的,不同设备在利用Non-IID的数据进行训练且epoch较大时,可能会出现过拟合的现象导致模型偏离全局模型

基于上述问题,作者基于FedAvg的基础做了部分改进(在客户端训练的loss函数中加入正则项),提出了新的框架FedProx

2 Method

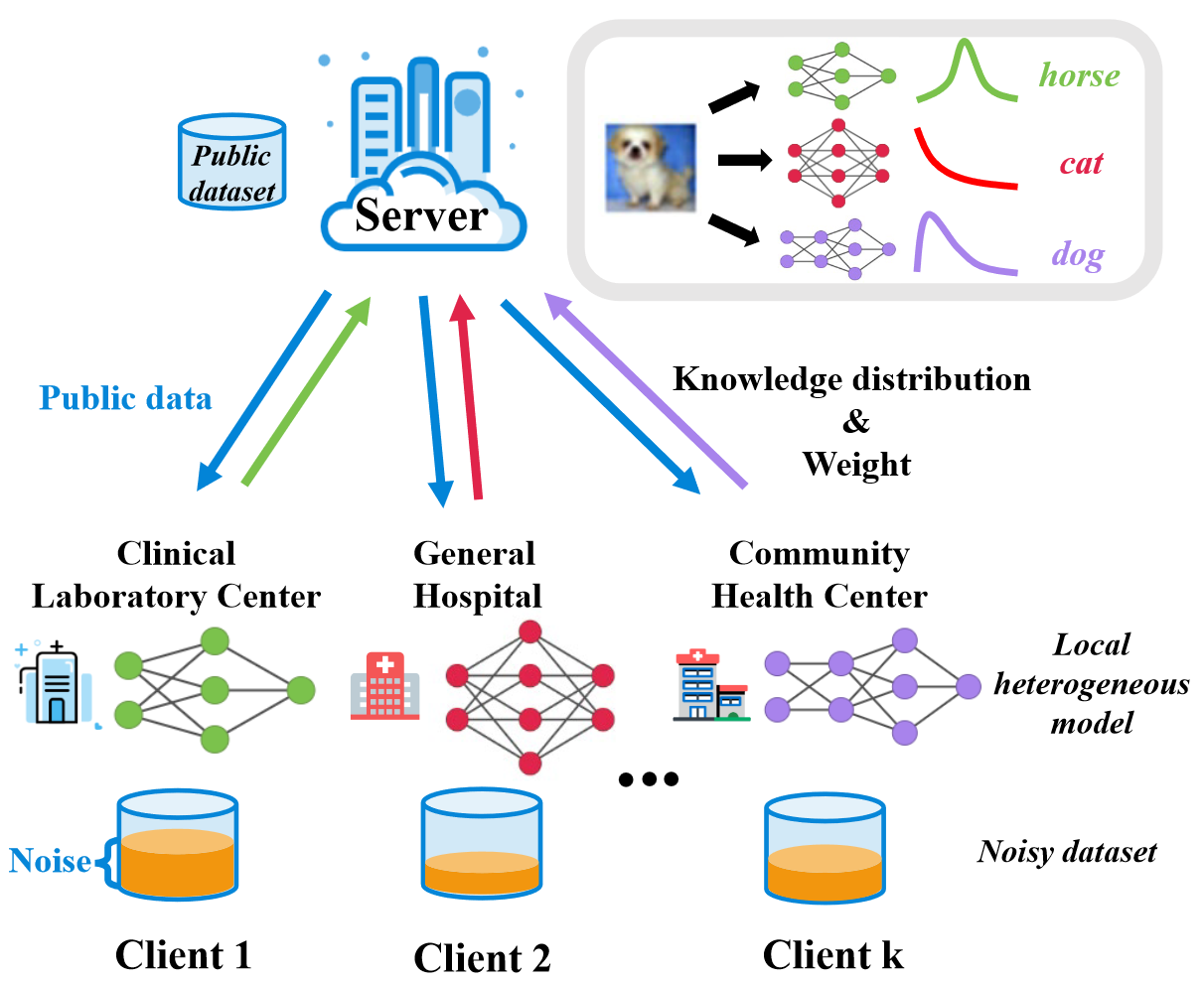

针对系统异构问题:

FedProx允许出现训练不充分的客户端模型,在固定epoch的情况下,不论一个客户端是否完成了本地训练,FedProx都会整合当前通信轮次中所有参与训练的客户端模型,定义解决方案如下:

算法伪代码:

3 Experiments

4 Conclusion

本博客所有文章除特别声明外,均采用 CC BY-NC-SA 4.0 许可协议。转载请注明来自 AriaZone!